Esta nota examina la energía que requiere el cerebro humano comparando su funcionamiento con el de las computadoras que lo emulan. Sumergidos en cifras monumentales y para evitar posibles gaffes técnicos mencionamos pocos datos para una mejor perspectiva del asunto, un poco al estilo de las arcaicas secciones periodísticas tipo “Divúlguelo” o “¿Sabía Ud. que…?” que atesoramos en nuestros chips naturales.

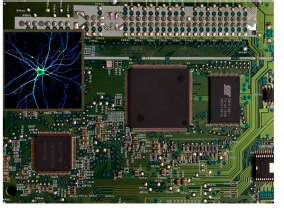

Los chips o circuitos integrados convencionales se estructuran con unidades separadas de control, procesamiento y memoria y un consumo considerable de energía, 50-100 W por cm2 de circuito. Son ideales para el procesamiento de operaciones lógicas con extrema rapidez, una a la vez, que deben ser transferidas a la unidad de memoria antes de la siguiente operación por su arquitectura seria, que nos trae el recuerdo de la excelencia del Fortran, el lenguaje que utilizábamos hace decenios. La Sequoia, una supercomputadora con 1.5 millones de chips y 1.5 petabytes (1015 bytes) de memoria simula la conectividad de 500 x 109 neuronas y 100 billones de sinapsis, aunque la velocidad es solo 1/1500 de la del cerebro humano.

Igualar esa velocidad no es solo cuestión de dinero sino de consumo eléctrico, por la cantidad de chips que se requerirían para 12 GW, la energía eléctrica destinada a Los Ángeles y Nueva York 1. Los chips son insaciables consumidores de energía a los que se destinan variados mecanismos de disipación del calor que generan, desde el ventilador en las PC, hasta circulación de agua y otros sofisticados procesos.

Los nuevos circuitos integrados se desarrollan con premisas elementales de los procesos cognitivos: reconocimiento de patrones, memoria, aprendizaje y actividad motora. Repasemos algunas características de este “hardware natural” y su funcionamiento, apoyados en casi un centenar de miles de millones de neuronas y una enorme red sináptica: un lenguaje eléctrico común, potenciales de receptores y postsinápticos, graduados y pasivos y potenciales de acción, unidades discretas en el tiempo, activos y propagados; ambos modos con similares características en los numerosos tipos celulares y en casi todas las especies, al igual que con los tipos de neurotransmisores, simplificaciones invalorables para su estudio.

La arquitectura funcional es conectiva, con distribución informativa simultánea en serie y en paralelo, vías anatómicas con salvaguarda de la información en caso de anulación de una de ellas, y con un volumen de información acotado debido al umbral que debe alcanzar para transmitirse (event-driven processing).

Por esto un segmento de la retina no registra una nueva información redundante, el pixel de una cámara digital sí lo hace. Todo esto aumentando la precisión y eficiencia energética.

Con los nuevos circuitos que se apoyan en esta arquitectura se han obtenido sustanciales logros en reconocimiento de imágenes y de la voz, procesamiento del lenguaje y juegos, y prueba de esto es que en 2014 IBM presentó un chip neuromórfico, el TrueNorth, con 5400 millones de transistores (5.4 × 109) conectados de forma tal que semejan 1 millón de neuronas digitales y 256 millones de contactos (sinapsis) controlados por programas 2. El ensamblaje de 16 chips en un pequeño robot es espectacular: el artilugio distingue autos, pedestres, bicicletas y otros elementos y los incrédulos pueden ver este prototipo en un video de YouTube 3. Si esto parece mucho, sus desarrolladores aspiran a otro circuito con 4096 chips ensamblados y un billón de sinapsis consumiendo módicos 4 kW. Una reciente estrategia fue publicada en Nature (portada incluida) con un chip híbrido, el Tianjik, que une el aprendizaje en base a algoritmos computacionales con una estructura basada en los circuitos cerebrales. El chip con una área de 3.8 mm2 contienen el equivalente de 40 000 neuronas y 10 millones de sinapsis y una velocidad de 1.28 teras (billón) operaciones/seg por watt de consumo 4.

Aun corriendo el riesgo de ser incorporados a los simplificadores extremos: el corazón remeda el carburador de un auto y el ojo a una cámara fotográfica, vale la pena un par de aproximaciones al funcionamiento de las computadoras y del cerebro. A grosso modo los científicos computacionales asemejan el funcionamiento de las antiguas computadoras al del hemisferio cerebral izquierdo, ideal para operaciones rápidas, con símbolos y cálculo, y el de las nuevas generaciones al del hemisferio derecho, más lento, y capaz de reconocer patrones y estímulos sensoriales. Los circuitos electrónicos se basan en millones de transistores, cuyas propiedades semiconductoras permiten que funcionen como interruptores on/off a velocidades de hasta 210 GHz 5. Con esto, las computadoras representan una increíble variedad de información, aunque cada una reducida a los on/off de los transistores que operan como llaves de corte; el bit traducido en una notación en base dos con ceros y unos para los números y a un octeto de bits, el byte, para cada letra del alfabeto (de paso escribimos CHIPS en ese formato).

Por su parte, la sinapsis es un transductor natural que convierte energía eléctrica –el impulso nervioso– en energía química, la neurotransmisión en múltiplos de unidades elementales (definida como cuántica hace más de medio siglo, cuando ese término estaba restringido a la física) y nuevamente eléctrica en la siguiente neurona. Una forma de comunicación mucho más lenta que el on/off de los transistores, con un retardo de 0.3 a 5 mseg en cada sinapsis (excluimos las sinapsis eléctricas), y la propagación del impulso en decenas de metros/seg, varios órdenes de magnitud mayores a los tiempos electrónicos, pero es su número, la arquitectura y la forma en que efectúan ese si/no lo que las hace más eficientes que los equipos artificiales, por ahora…

Para evitar el límite de la miniaturización de los transistores, hasta ahora los más pequeños son de 14 nm –unos 70 átomos de silicio–, y que por las reglas de la física empleada pueden anular las propiedades del transistor, se desarrollan nuevos chips y computadoras basados en la física cuántica, con cúbits o bits cuánticos no asociados a un sistema físico concreto y reemplazo de los bits, capaces por esta derivación de representar no 0s o 1s sino ambos valores a la vez (¿se entiende, no?), y el único modelo cerebral que importa aquí es el de los inventores. Por ahora son informes preliminares, talk of the town, con disputas de prioridad entre los gigantes IBM y Google, con ventajas extraordinarias en boca de sus inventores, respuestas de los competidores y advertencias de un posible “invierno cuántico” (léase disminución de las inversiones, de no ser factibles a mediano o corto tiempo) 6. La foto del equipo cuyos procesadores operan cerca del cero absoluto (–273 °C) nos recuerda los engendros de las películas de ciencia ficción.

Su funcionamiento está fuera del alcance de este redactor por sus fracasos en entender la física cuántica, un posible Golem que atrae y obnubila en forma simultánea a los advenedizos que intentan hurgar en sus entrañas, aunque, eso sí, nos proporciona, casi por caridad, una fuente inagotable de vocabulario para las conversaciones de avanzada. De todas maneras está ya disponible para los bravos de espíritu el artículo en Nature (otra portada) 7.

Para consuelo aclaramos que los científicos, como los niños, se empecinan en los “por qué” y aquí faltan explicaciones por varios lados porque en el área de la inteligencia artificial 8 que de esto se trata, se acepta la deuda intelectual como un paño frío en la herida: la esperada respuesta se demora aunque no retarda la progresión del experimento.

¿Y cómo andamos con el consumo de nuestros cerebros? La cuenta es sencilla con las reglas de la física del siglo XIX: un ser humano requiere de unas 2000 kcal por día o 0.023 kcal (23 cal)/segundo, que transformados en watts (1 Watt = 1Joule/seg = 0.24 cal/seg) nos devuelve la módica cifra de 96 W diarios, de ellos unos 20 W destinados al funcionamiento de los miles de millones de neuronas (y de un número mucho mayor de células gliales), consumo ridículo, por ahora, respecto a los sistemas artificiales.

La ciencia está lanzada a alcanzar en los equipos el funcionamiento del cerebro, maravilla de maravillas de la evolución y resultado de pruebas y errores en el tiempo casi infinito con que cuenta la naturaleza. ¿Podrá?

1. Modha DS. Introducing a Brain-inspired Computer TrueNorth’s neurons to revolutionize system architecture. En: http://www.research.ibm.com/articles/brain-chip.shtml. 2. Merolla PA, Arthur JV, Alvarez-Icaza R, et al. Artificial brains. A million spiking-neuron integrated circuit with a scalable communication network and interface. Science 2014; 345:668-73. 3. https://www.youtube.com/watch?v=akSJ3NucBsc. https://www.youtube.com/watch?v=7ELRZrjCFd0. 4. Pei J, Deng L, Song S, et al. Towards artificial general intelligence with hybrid Tianjic chip architecture. Nature 2019; 572:106-11. 5. https://www.eetimes.com/document.asp?doc_id=1199863. 6. https://www.ft.com/content/b9bb4e54-dbc1-11e9-8f9b-77216ebe1f17. 7. Arute F, Arya K, Babbush R, et al. Quantum supremacy using a programmable superconducting processor. Nature 2019; 574:505-10. 8. Rabadan A. Horizonte de la inteligencia artificial y neurociencias. Acerca de robots, androides y cyborgs Medicina (B Aires) 2019, 79: 397-400.

Comentarios a Basilio A. Kotsias, kotsias@retina.ar